Mitte der 1990er Jahre ging man zum Telefonieren mit dem Handy aus dem Café raus auf die Straße. Man erntete teilweise skeptische Blicke von Passanten – Sprechen ohne sichtbares Gegenüber wirkt meist seltsam. Doch inzwischen haben wir uns an die scheinbar mit sich selbst Sprechenden gewöhnt – und reden alle immer mehr. Und das nicht nur mit anderen Menschen, sondern verstärkt auch mit Computern.

Aus Sicht der Konzeption ist das sehr interessant – denn es ergeben sich dadurch viele Möglichkeiten, aber auch einige Probleme.

Zunächst ein Blick in die Welt der geschriebenen Sprache als Möglichkeit, Computer zu steuern, dann kommen wir zurück auf die gesprochene.

Der Erfolg von Chat

SMS und vor allem ihr Nachfolger Instant Messaging wie WhatsApp oder Snapchat sind insbesondere für jüngere Nutzer nicht mehr aus dem täglichen Leben wegzudenken.

Mehr und mehr Dienste bieten heute auch virtuelle Assistenten, die über Chat mit den Nutzern kommunizieren („Chatbots“).

Das häufigst genannte Beispiel ist der chinesische Dienst WeChat. Per Textnachricht kann man über diesen Termine ausmachen, Taxis rufen, Einkaufen und Geld überweisen. WeChat hat über 762 Millionen Nutzer, den ganz überwiegenden Teil davon in China. Für viele Chinesen ist WeChat wichtiger als das Web, da sie die meisten Interaktionen über diesen Dienst abwickeln.

Interessant ist auch Amy. Dieser Dienst ist ganz auf das leidliche Thema Terminvereinbarung spezialisiert. Per E-Mail findet Amy einen passenden Termin, an dem alle Beteiligten Zeit haben.

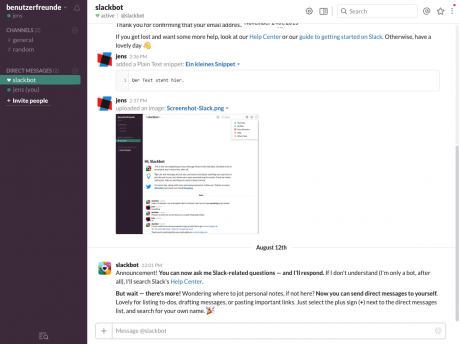

Schließlich gibt es noch Slack, eine Art WhatsApp für die Arbeit. In diesem schön gestalteten Messenger kann man sich mit seinen Kollegen per Text und Bild austauschen. Und der Chat-Bot von Slack selbst beantwortet Fragen zur Funktionsweise des Programms und führt auch geschickt in die Bedienung ein, wenn man sich anmeldet.

Assistentinnen im Anmarsch

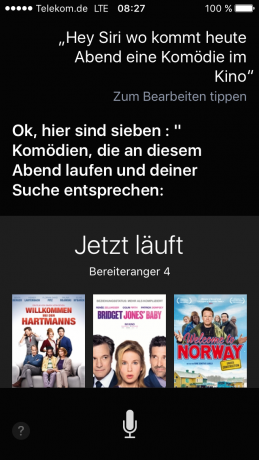

Seit 2011 gibt es im iPhone die Sprachassistentin Siri. Sie nimmt gesprochene Befehle entgegen und antwortet per Audio, oft zusätzlich mit visuellen Informationen auf dem Bildschirm ergänzt.

Auch auf Scherzfragen hat die virtuelle Assistentin eine Antwort. Für die Usability unbedeutend, für die UX aber wichtig. So entsteht eine persönliche Bindung an die Computer-Assistentin. Es gibt etliche Blogs, die sammeln lustige Antworten, etwa http://shitthatsirisays.tumblr.com

Auch andere Anbieter haben Assistentinnen:

- Bei Microsoft heißt sie Cortana.

- Amazon nennt sie Alexa.

- Nur Google verzichtet auf einen weiblichen Vornamen und hat den Assistenten Google Now getauft.

Bis diese so weit sind, wie Samantha im Film Her, wird es noch ein bisschen dauern. Aber wer zum Beispiel viel im Auto sitzt, freut sich über die Interaktionsmöglichkeit nur per Stimme.

Ob man aber eine Assistentin in Form eines Lautsprechers im Wohnzimmer haben möchte, der/die jedes Wort zu Hause mithört, darüber gehen die Meinungen auseinander.

Schon 1968 gab es Bedenken, Computern zu viel Macht über sein Leben zu geben: Der virtuelle Assistent HAL 9000 Stanley Kubricks Odyssee 2001 im Weltraum hatte zwar perfektes Sprachverständnis, doch auf die Bitte des Captains der Raumschiffbesatzung, sie am Leben zu lassen, meinte er nur:

I’m afraid I can’t do that, Dave.

Probleme mit der akustischen „Benutzeroberfläche“

Aber wir schlagen uns heute glücklicherweise mit ganz anderen Problemen herum. Und das sind vielfach keine Probleme, bei denen es den Computern an (künstlicher) Intelligenz fehlt. Es sind Probleme, die in der Natur der Sache liegen. Einige Dinge lassen sich mit Sprachsteuerung nur sehr umständlich erledigen, die auf einem Bildschirm ganz einfach sind.

„Discoverability“ (Entdeckbarkeit) ist ein solches Problem – das heißt, wenn ich nicht genau weiß, wie das heißt, was ich gerade suche, wird es kompliziert. Denn das kann ich dem virtuellen Assistenten dann auch nicht sagen.

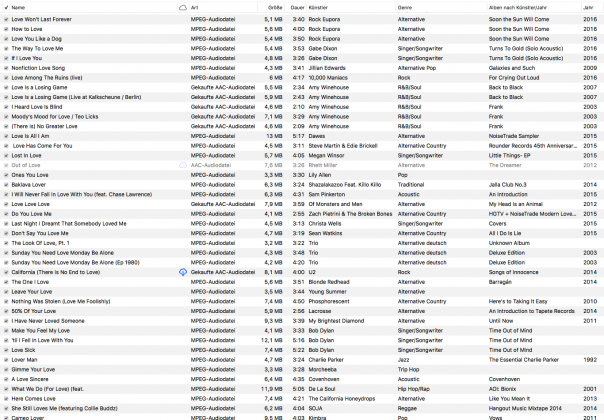

Sehe ich dagegen eine Liste vor mir, dann finde ich das Gesuchte oft sehr schnell. Bestes Beispiel: Titel von Liedern oder klassischen Stücken. Wenn ich die Liste von Liedern sehe, weiß ich sofort, welches ich gerade hören will. Aber dennoch kann ich mich nicht unbedingt an den Titel aktiv erinnern.

Generell sind lange Listen schwierig. Das wird natürlich besser, wenn die Assistenten besser werden und uns besser kennen – dann brauchen wir vielleicht weniger oft lange Listen. Wenn wir sagen können: „Spiel mir das Liebeslied, das meine Frau so gern hört, du weißt schon, das, was wir neulich beim Abendessen gehört haben, als es Kürbissuppe gab.“, dann brauchen wir zumindest für diese Suche keine Listen mehr.

Wenn es bei einer Suchanfrage mehr als drei, vier Treffer gibt, stößt man mit Vorlesen auch schnell an die Grenzen. Frage ich einen Assistenten etwa nach einem italienischen Restaurant, das im Umkreis von 3 Kilometern liegt und heute Abend auf hat, können das schnell mal 20 Treffer werden. Soll der arme Assistent mir alle vorlesen? Oder nur die ersten drei? Aber nach welchen Kriterien sucht er sie aus? Entfernung? Alphabet? Bewertungen?

Das zeigt auch: Hat eine Liste mehrere Dimensionen, wird es noch schwieriger. Ich kann solche Trefferlisten nach vielen Dimensionen sortieren, eben etwa nach Entfernung, Bewertungen oder Preisspanne. Aber welche Dimensionen das sind, das müsste mir der Assistent auch wieder erst vorlesen. Und dann kann ich die Liste immer noch nicht schnell überfliegen.

Und auch mit weiteren Meta-Informationen ist es schwierig. Mir ist vorher vielleicht gar nicht bewusst, woran ich das Lied erkenne. Vielleicht daran, dass es das zweite auf dem Album ist. Oder daran, dass sein Titel länger ist als der aller anderen Stücke auf dem Album. Oder vielleicht daran, dass es nur 1:13 dauert. Das habe ich aber vielleicht gar nicht so im Kopf, dass ich es in Worten ausdrücken kann.

Ein großes Problem aus User Experience-Sicht ist: Wenn Menschen einen Computer nicht dazu bringen, das zu tun, was sie wollen, dann fühlen sich die Menschen meist selbst schlecht. Sie beziehen den Fehler mehr oder weniger unbewusst auf sich selbst. Und wer will schon viel mit einem Gerät umgehen, das einem ein schlechtes Gefühl gibt?

Daher antwortet Siri auch öfter mit Bildern oder Listen.

Und noch ein wichtiges Problem: Je mehr Geräte sich per Sprache steuern lassen, desto größere Konflikte gibt es. Die Schar meiner Assistenten muss wissen: Mit wem spreche ich eigentlich? Sage ich etwa: „Stell die Temperatur auf 225 Grad“, sollte mein Backofen reagieren – der Heizungsthermostat wird aber vielleicht antworten: „Das habe ich leider nicht verstanden.“ Hoffentlich.

Und wenn ich mit Siri in meinem iPhone spreche, dann sollten die Siris meiner fünf Freunde am Tisch nicht auch reagieren.

Für alle diese Probleme gibt es Lösungsansätze, aber perfekt ist die Umsetzung noch nicht – für UX-Experten gibt es noch einiges zu tun.

Welche Stärken hat die Sprachsteuerung?

Nach so vielen Problemen zu den positiven Seiten: Sprachsteuerung hat viele gute Einsatzfälle. Zum Beispiel immer dann, wenn man keine Hand frei hat – also etwa im Auto.

Oder wenn es keine guten alternativen Eingabemöglichkeiten gibt. Also z.B. bei Smartwatches oder Fernsehern. Auf der Smartwatch tippen? Geht nicht richtig. Text per Fernbedienung eingeben? Eine Qual.

In naher Zukunft kommen weitere Einsatzfälle hinzu: Wenn man eine Virtual Reality-Brille oder eine Augmented Reality-Brille trägt, dann ist die Eingabe per Tastatur oder traditioneller anderer Eingabegeräte umständlich bis unmöglich.

Auch wenn man persönlicher wirken will, sind Sprachassistenten hervorragend. Also z.B. bei Automaten, die vor allem von Nutzern verwendet werden, die das nicht häufig tun.

Und natürlich helfen sie allen den Menschen sehr, die körperliche Einschränkungen haben und deshalb Maus und Tastatur oder Touchscreens nicht bedienen können.

Herausforderungen für gute Sprachsteuerung

Guter Text

Nachdem Text das einzige ist, was die Nutzer bei der Sprachsteuerung wahrnehmen (abgesehen von der Qualität der Stimme), ist es ganz zentral, diesen perfekt zu machen.

Microsoft z.B. hat für Cortana ein Redaktionsteam – jede Meldung hat ein Mensch geschrieben. Das heißt, es steckt eine Menge klassischer Redaktionsarbeit hinter der Maschine. Und das zahlt sich aus, denn so wird die Assistentin als eine Persönlichkeit wahrgenommen, es entsteht eine persönliche Bindung. 14 Prozent der Anfragen an Cortana sind Smalltak, bei denen die Nutzer einfach nur ausprobieren, was die Assistentin kann oder sich mit ihr einfach unterhalten.

Korrekter Kontext (nicht zu viel, nicht zu wenig)

Antwortet ein Assistent per Sprache zu lang, ist das nervig – man muss warten, bis er fertig ist oder bis er endlich die gesuchte Information sagt.

Zu kurz dagegen kann irreführend sein, oder missverständlich.

Und was zu lang oder zu kurz ist, das hängt stark vom Kontext ab. Ebenso vom Kontext hängt ab, was mir überhaupt sinnvoll angeboten werden kann.

Cortana bietet z.B. nur an, eine eintreffende Nachricht vorzulesen, wenn der Kopfhörer eingesteckt ist. Ist er das nicht, sind vermutlich andere um mich herum, und ich lese die Nachricht lieber selbst als Text auf dem Bildschirm.

Steuerbarkeit

Man muss die Sprachausgabe immer unterbrechen können. Gerade bei Dialogen, die man oft führt.

Die Gefahr dabei ist: Der Nutzer meint zu wissen, was kommt, hört es aber nicht, weil er den Computer unterbrochen hat. So können schnell Missverständnisse entstehen – welche der Computer im Idealfall vorhersieht und schnell korrigieren kann.

Konsistenz

Wörter, die der Computer verwendet, sollte er selbst auch verstehen. Sagt er etwa: „Soll ich die Nachricht vorlesen?“, sollte er „Nachricht vorlesen“ verstehen und am besten immer diese Konstruktion verwenden.

Verwendet der Assistent abwechselnd „vorlesen“, „lesen“ oder andere Synonyme/Konstruktionen, dann ist es für die Nutzer viel schwieriger, sein Vokabular zu lernen und die Wörter zu behalten, mit denen man die Funktionen aufruft.

Passender Ton

Sehr schwierig ist auch, den richtigen Ton zu treffen. Will ich meinen Assistenten lieber klingen lassen wie einen

- Kollegen

- Lehrer

- Beamten

- Hipster

- Teen

Wechsle ich hier zu sehr durch, entsteht ein ungutes Gefühl beim Benutzer – wir erwarten auch von virtuellen Persönlichkeiten eine gewisse Vorhersagbarkeit, wir wollen wissen, mit wem wir es zu tun haben.

Gutes Timing

Kommen die Antworten zu schnell oder spricht der Computer zu schnell, fühlen sich die Nutzer gestresst.

Braucht er zu lange, werden sie ungeduldig.

Nicht zu perfekt

Wirkt der Computer, als würde er alles verstehen, erwarten die Nutzer genau das von ihm. So wie Ihnen im Ausland jemand vielleicht in seiner Sprache antwortet, nur weil sie eine korrekt ausgesprochene Begrüßung beherrschen – aber sonst leider nichts in dieser Sprache.

Fazit

In vielen Einsatzbereichen werden wir immer mehr Sprachsteuerungen und virtuelle Assistenten sehen. Diese ist zum einen komplexer als eine Steuerung mit Maus und Tastatur, außerdem gibt es in diesem Bereich noch weniger Erfahrungen. Usability-Tests sind also hier besonders wichtig.

Damit es nicht am Ende immer wieder nur heißt:

I’m afraid I can’t do that, Dave.

Linktipp

Peter Morville (Autor von Information Architecture) schreibt sehr schlau und witzig über seine Erfahrung mit Alexa und seine Einschätzung der weiteren Entwicklung der Sprachsteuerung:

Conversational Information Architectures

8 Gedanken zu „Sprechen mit Computern – Newsletter 11/2016“