In den letzten Newslettern ging es darum, wie Sie durch Ihre Website oder Anwendung mit Ihren Nutzern gut kommunizieren. Dabei gilt die Binsenweisheit:

Man kann nicht nicht kommunizieren.

Selbst wenn Sie jemandem, der Sie anspricht, nicht antworten, selbst dann sagen Sie damit etwas aus. In diesem Fall etwas wie „Lass mich in Ruhe!“

Genauso wird die Reaktion oder eben die Nicht-Reaktion Ihrer Site vom Besucher als Kommunikation gewertet.

In Zukunft wird es immer mehr Möglichkeiten geben, in eine direkte Kommunikation mit dem Nutzer zu treten. Das passiert jetzt schon, wenn Sie z.B. eine Fehlermeldung ausgeben: Sie „sagen“ dem Nutzer, was das Problem ist und geben ihm im Idealfall Tipps, wie er es lösen kann.

Immer mehr Kommunikationskanäle

Es bleibt nicht bei schriftlichen bzw. eingetippten Text. Wir kommunizieren mit Maschinen vermehrt auch über folgende Benutzerschnittstellen:

- Gesprochene Sprache

- Gesten

- Blicksteuerung

- und sogar Gedanken

Solche Systeme werden immer schlauer. Einen Blick in die gar nicht so ferne Zukunft können Sie im Spielfilm Her werfen (über den ich hier geschwärmt habe: So sieht die Benutzeroberfläche der Zukunft aus: unsichtbar).

Jeder, der interaktive Systeme gestaltet, kann nur gewinnen, wenn er sich die kleine Fortbildung gönnt und sich den Film an einem ruhigen Abend ansieht.

Im Folgenden noch ein paar weitere Inspirationen – die meisten davon sind jetzt schon Wirklichkeit und werden beeinflussen, wie wir in Zukunft mit Maschinen umgehen.

Sprachausgabe

Maschinen, die Sprache ausgeben, sind ein alter Hut – die ersten Versuche mit Wachswalzen wurden im 19. Jahrhundert durchgeführt, mit der Erfindung des Grammophons 1887 wurden sprechende Maschinen für uns Menschen Alltag.

Doch richtig interessant wird es, wenn man nicht auf Texte festgelegt ist, die ein Mensch vorher eingesprochen hat, sondern wenn die Maschine jeden beliebigen Text selbst als gesprochene Information ausgeben kann.

Das machen zum Beispiel Navigationsgeräte heute schon hervorragend. Wenn der Wortschatz und damit die Laute beschränkt sind, dann kann man die Algorithmen so anpassen, dass es schwierig wird, eine menschliche von einer maschinellen Stimme zu unterscheiden.

Capsule.fm

Auch über Capsule.fm habe ich vor einiger Zeit schon berichtet (Das persönliche Radioprogramm – willkommen in der Zukunft). Capsule weckt seinen Nutzer mit einer Mischung aus aktuellen Nachrichten, Musik und dem Wetterbericht. Das Besondere dabei: Es spricht kein Radiomoderator und es hört nicht jeder Hörer das Gleiche. Vielmehr bekommt jeder Nutzer eine einzigartige Mischung von Information und Musik serviert, die ganz auf seine Vorlieben ausgerichtet ist.

Möglich machen das eine noch relativ grobe Auswahl von Inhalten verschiedener Nachrichten-Sites sowie die synthetische Stimmerzeugung im Mobiltelefon.

Die Kommunikation bei Capsule ist derzeit noch eine Einbahnstraße. Die Stimmen lesen Nachrichten vor. Aber dennoch sehen Sie hier, wie gute Kommunikation mit einem interaktiven System funktioniert. Denn es wird nicht nur vorgelesen, sondern die „Sprecher“ fügen die Informationshäppchen mit sozialem Kitt zusammen.

So wie ein Radiomoderator verbinden sie die Inhaltselemente mit wenigen Sätzen. Die meisten Moderatoren im Radio wie auch im Fernsehen sind aus inhaltlicher Sicht überflüssig – achten Sie bei nächster Gelegenheit einmal darauf, wenn Sie eine Magazinsendung sehen oder hören. Die Aufgabe der Moderatoren ist vor allem, die Beiträge miteinander zu verbinden, Überleitungen zu schaffen und dem Zuhörer bzw. Zuschauer ein gutes Gefühl zu geben – kurz, die Sendung menschlich zu machen.

Capsule.fm wird kein Nutzer als menschlich oder gar schlau bezeichnen. Jeder durchschaut, wie das System funktioniert, und selbst wenn es dem Nutzer gelegentlich Komplimente macht, nimmt niemand das Programm als Gesprächspartner wahr.

Und doch entsteht ein Gefühl der Verbundenheit, der Persönlichkeit, weil die Kommunikation des Programms auf den Grundregeln der menschlichen Kommunikation aufbaut.

HitchBOT

Eine echte Kommunikation, wie sie sich die meisten vorstellen, kommt mit dem Roboter HitchBOT zustande.

HitchBOT ist eine Tonne, die an der Autobahn steht und ihren Daumen herausstreckt – sie trampt. Wer sie mitnimmt, wird mit einem Gespräch mit dem Roboter belohnt. Dieser betreibt wie ein menschlicher Anhalter Small Talk und sorgt ebenso dafür, dass seine eigenen körperlichen Bedürfnisse nicht zu kurz kommen: Wenn sein Akku zur Neige geht, bittet er darum, sein Ladekabel in die Zigarettenanzünderbuchse des Autos zu stecken.

HitchBOT ist das Kind der Forscher Frauke Zeller und David Harris Smith, die an kanadischen Unis lehren und forschen.

Sie haben den unterhaltenden Roboter gebaut, um die Diskussion darüber anzuregen, wie Menschen und Roboter interagieren – und natürlich, um Erkenntnisse zu dieser Interaktion zu gewinnen.

21 Tage brauchte der Roboter für seine 6.000 Kilometer lange Reise von der Ost- zur Westküste Kanadas. 19 Autofahrer hatten ihn mitgenommen.

Chatbots

Chatbots, also Gesprächsroboter, gibt es schon seit den 1960er Jahren des letzten Jahrhunderts. Ende der 90er Jahre waren sie auch auf Websites in Mode.

Viel konnten sie nicht, aber die Besucher fanden es spannend, auszuprobieren, wie die Automaten auf ihre Fragen reagierten. Es war eine Mischung aus Neugier und Freude an der Kommunikation.

Heute geht die Entwicklung z.B. dahin, Support mit Hilfe von Chatbots zu automatisieren. Gerade bei technischen Anfragen beim Support von Hard- und Software sind die Fragen so spezifisch, dass eine Software nur wenige Schlüsselwörter zu erkennen braucht, um eine Antwort zu geben, die in den meisten Fällen weiterhilft.

Und auch im Marketing kommen Chatbots wieder zum Einsatz. Diesmal nicht auf Websites, sondern in Nachrichten-Apps. Der US-amerikanische WhatsApp-Konkurrent Kik Messenger zum Beispiel bietet Werbekunden Chatbots an, die sich mit den Nutzern dann über vorgegebene Themen unterhalten und so eine zusätzliche Kundenbindung erzeugen sollen.

Sprachsteuerung & Virtuelle Assistenten

Der nächste Schritt sind virtuelle Assistenten. Die nehmen nicht nur getippten Text entgegen, sondern hören auch zu.

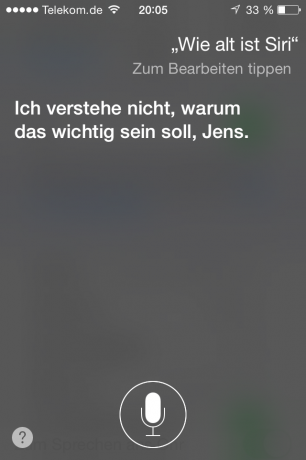

Apples Siri hat 2011, als die virtuelle Assistentin des iPhone zum ersten Mal in der Öffentlichkeit auftrat, viel Medienaufmerksamkeit bekommen.

Inzwischen ist die Anfangseuphorie vorbei. Viele Nutzer geben ihre Kommandos wieder per Tippen auf dem Display ein, weil es oft schneller ist und sich weniger komisch anfühlt, als in der Öffentlichkeit mit einer Maschine zu reden – die einen dann doch zu häufig nicht ganz richtig versteht.

Doch Apple hat gerade das Team der Siri-Entwickler vergrößert. Und die ersten Entwickler von Siri haben sich selbstständig gemacht und arbeiten an einem noch schlaueren System.

Microsoft hat 2014 mit Cortana eine Konkurrenz zu Siri auf seine Windows Phones gebracht. In Windows 10 soll diese virtuelle Assistentin auch ihren Weg auf den Desktop finden.

In der Form von Telefoncomputern kennen wir alle Sprachsteuerung schon seit Jahren – und empfinden sie als das, was sie sind: Der Versuch von Unternehmen, Geld zu sparen, indem man Standardanfragen Computern beantwortet lässt.

Und das auf Kosten der Kunden, denen die Mühe aufgebürdet wird, mit überdeutlicher Aussprache, Verwenden von Ziffern und umständlicher Navigation ihr Anliegen maschinenverständlich vorzutragen.

Gestensteuerung

Steuerung mit Bewegung ist derzeit noch ein Nischen-Thema, wenn man von den allgegenwärtigen Wisch-Gesten absieht, mit denen wir Touchscreens von Smartphones, Tablets etc. bedienen.

Die große Geste, also die Steuerung ohne Screen, findet sich noch nicht bei vielen Geräten. Am weitesten verbreitet sind sie wohl in der Spiele-Branche: Nintendo Wii, Microsofts Kinect oder Playstation Move erlauben es, Spiele nicht nur mit einem kleinen Controller in der Hand, sondern mit Armbewegungen oder sogar mit dem ganzen Körper zu steuern.

Aber es geht auch etwas kleiner: Schüttelt man ein iOS-Gerät, dann fragt es, ob man die letzte Aktion zurücknehmen möchte. Also zum Beispiel das Löschen eines Textes.

Daran sieht man auch ganz gut ein grundlegendes Problem, das jede Gestensteuerung hat: Solche eine Geste muss man kennen bzw. lernen. Anders als Buttons auf einem Screen können Gesten nicht selbsterklärend sein.

Im besten Fall sind sie intuitiv, aber auch das ist leichter gesagt als konzipiert, wie Malte Krökel und Ina Wulf auf der Mensch und Computer 2014 gezeigt haben. Sie haben die Leap Motion getestet – ein kleines Zusatzgerät, das für Mac und Windows-PCs eine Gestensteuerung nachrüstet.

Sie haben festgestellt, dass

- Gesten uneinheitlich verwendet werden

- viele Anwendungen Gesten nutzen, die weder intuitiv noch selbsterklärend sind bzw. die man sich kaum merken kann

- oft versuchen, die Maus-Interaktion mit Gesten nachzubilden, statt Gesten zu verwenden, die Interaktionen mit realen Objekten nachbilden

Haptik

Noch spannender wird es, wenn auch die Geräte einen weiteren Kommunikationskanal nützen können und uns im wörtlichen Sinn berühren.

Erste Ansätze sind die Vibrationsfunktionen von Handys. Für Blinde gibt es Braille-Zeilen, die Schrift in ein Muster von kleinen Erhebungen umwandeln, die Blinde mit den Händen „lesen“ können. Displays, die Informationen nicht nur anzeigen, sondern auch dreidimensional hervorheben, können aber für alle Menschen sehr hilfreich sein.

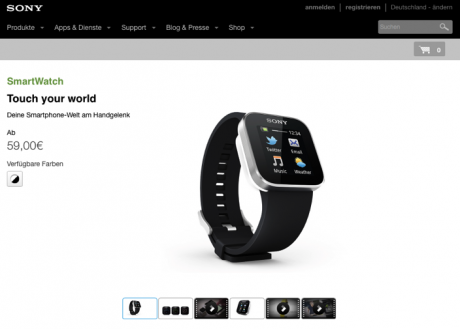

Uhren

Unauffällig anstupsen kann einen ein Gerät, das erst nächstes Jahr auf den Markt kommt: die iWatch, die Uhr von Apple. Das soll die Vibrationsfunktion von Smartphones ersetzen – die man ja meist entweder nicht bemerkt (weil das Handy irgendwo in der Tasche vibriert) oder die stört (weil das Handy auf dem Tisch liegt und dort störend rumort).

Schon seit einiger Zeit gibt es Smart Watches, von Samsung und anderen Anbietern – aber so richtig durchgesetzt haben sie sich nicht.

Ein wichtiger Grund dürfte der Stromhunger dieser Uhren sein. Auch die iWatch etwa muss einmal am Tag zum Laden an die Steckdose.

Ein weiterer wichtiger Grund: Die Steuerung dieser Minigeräte ist gar nicht einfach umzusetzen. Wir dürfen gespannt sein, was die Ingenieure von Apple hier vorlegen.

Wearables

Solche Uhren gehören zur Kategorie der Wearables , am Körper zu tragender Computer. In diesem Bereich tut sich ebenfalls viel. Vor allem bei Medizin und Fitness – die Überwachung von Körperfunktionen ist für beide interessant.

Ob und wie man mit diesen direkt etwas steuern will, das muss jeder für sich entscheiden. Denkbar und sinnvoll ist aber sicher, dass etwa eine Software für Diabetiker im Fall eines Unterzucker-Schocks automatisch einen Arzt verständigt.

Google Glass, Augen- und Blicksteuerung

Nicht fehlen in der Reihe innovativer Interfaces darf Google Glass. Diese Brille gibt Informationen so aus, dass sie für den Träger im Sichtfeld erscheinen und dort etwa ein Achtel des Platzes einnehmen.

Nützliche Anwendungen sind Navigation, aber auch wichtige Nachrichten, Infos über das, was man gerade ansieht etc.

Die Steuerung erfolgt über ein kleines Touch-Feld am Brillenrand oder per Sprachbefehlen.

Noch ganz ausgereift scheint das noch nicht, aber einige Nutzer sind recht begeistert von dem Gerät – und viele Programmierer und Konzepter tüfteln an neuen, innovativen Anwendungsmöglichkeiten.

Durch Neigen des Kopfes kann man Google Glass aktivieren – ich vermute, bald kann man auch durch Blinzeln oder Fixieren von angezeigten Elementen eine Auswahl treffen.

Gedankenkontrolle

Für die meisten Menschen am unheimlichsten wird es, wenn wir in den Bereich der Gedankensteuerung vorstoßen. Man spricht hier von Gehirn-Maschine-Schnittstellen (Brain-Machine Interfaces – BMI).

Hirnströme sind etwas, was im EEG seit Jahrzehnten gemessen wird. Allerdings können sie nur gut Auskunft geben darüber, ob mit unserem Hirn alles in Ordnung ist und darüber, auf welchem Aktivitätsniveau wir sind. Also ob wir zum Beispiel schlafen oder wach sind.

Doch die Messmethoden werden immer ausgefeilter. Mit dem Sensor von Neurosky etwa kann man bereits Fotos mit Google Glass schießen, einfach nur, indem man sich konzentriert. Oder in einem Spiel LKWs durch die Gegend werfen.

Und Honda hat ein Gerät vorgestellt, das zwar noch die Größe von zwei Ohrensesseln hat, aber es erlaubt, die Bewegung eines Roboters komplett mit seinen eigenen Gedanken zu steuern.

Und ist man bereit, sich einem operativen Eingriff zu unterziehen, dann kann die Steuerung noch sehr viel präziser werden. Das ist heute sicher nichts für einen Massenmarkt. Aber wer eine Lähmung hat oder künstliche Gliedmaßen steuern möchte, der ist zu so etwas sicher meist bereit. So kann man elektrisch gesteuerte Arm- oder Beinprothesen mit noch vorhandenen Nerven verknüpfen. Der Patient gewinnt so ein Maß an Bewegungsmöglichkeiten zurück, das man bis vor Kurzem nicht für möglich gehalten hat.

Was ist Ihre Zukunftsvision? Welche Möglichkeit der Kommunikation mit Maschinen hätten Sie gern? Vor welchen gruselt es Ihnen vielleicht?

2 Gedanken zu „Reden mit Maschinen – Benutzerschnittstellen der Zukunft – Newsletter 10/2014“